欢迎阅读这篇教程,我们将向您展示如何在本地部署 DeepSeek 大模型,实现数据本地化安全和定制的灵活性。本次搭建采用 Ollama + Chatbox 方案,搭建的是 DeepSeek R1 1.5B 版本,无需独立显卡,纯 CPU 推理即可使用。所有相关工具的下载地址都放在文章底部。

模型硬件要求说明

不同的 DeepSeek 模型对硬件的要求有所不同:

-

DeepSeek 1.5B:15 亿参数(小型模型,适合轻量级任务)

-

DeepSeek 7B:70 亿参数(主流规模,平衡性能与资源)

-

DeepSeek 70B:700 亿参数(高性能需求场景)

-

DeepSeek 671B:6710 亿参数(超大规模,对标 PaLM/GPT-4)

-

安装ollama

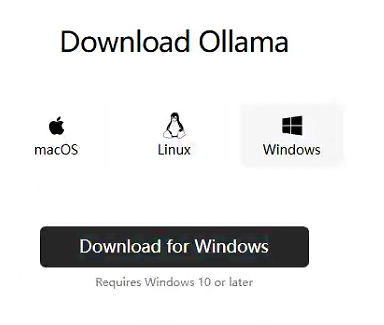

前往 Ollama https://ollama.com/ 官网 下载安装包。如果官网下载速度较慢,可以使用文章底部提供的网盘地址。

注意:请根据您的系统选择对应的安装包,这里以 Windows 系统为例。

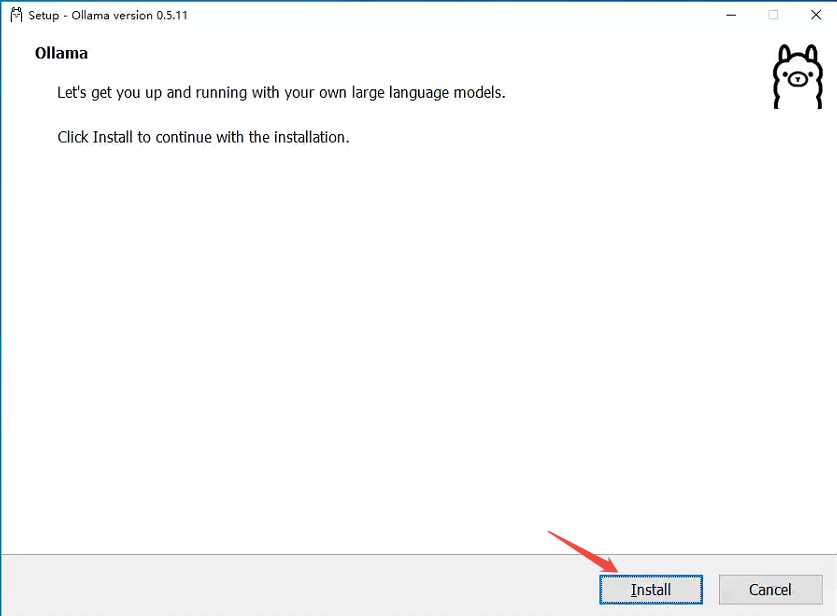

下载完成后,开始安装 Ollama。

-

拉取模型

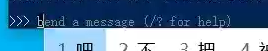

以管理员身份打开 Windows PowerShell,然后输入以下命令:

ollama run deepseek-r1:1.5b按下回车键后,进度条会显示正在下载模型。

如果下载过程中速度变慢,可以按

Ctrl + C 取消下载,然后再次执行命令。Ollama 支持断点续传功能。3.模型安装完成

模型安装完成后,您就可以直接输入问题进行测试了。反应速度其实很快,您可以感受到本地部署的优势。

4.安装及配置 Chatbox

为了方便随时随地访问 DeepSeek,可以安装 Chatbox 并通过图形化界面进行操作。前往 Chatbox AI 官网 https://chatboxai.app/zh 下载安装包。

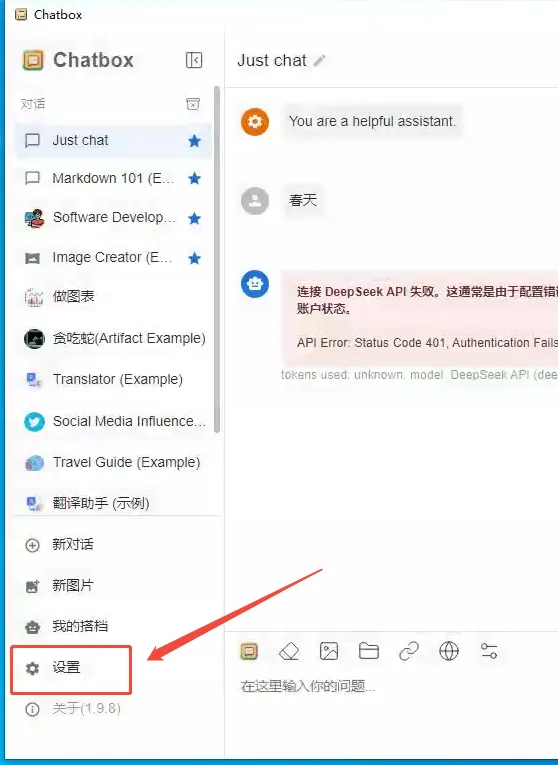

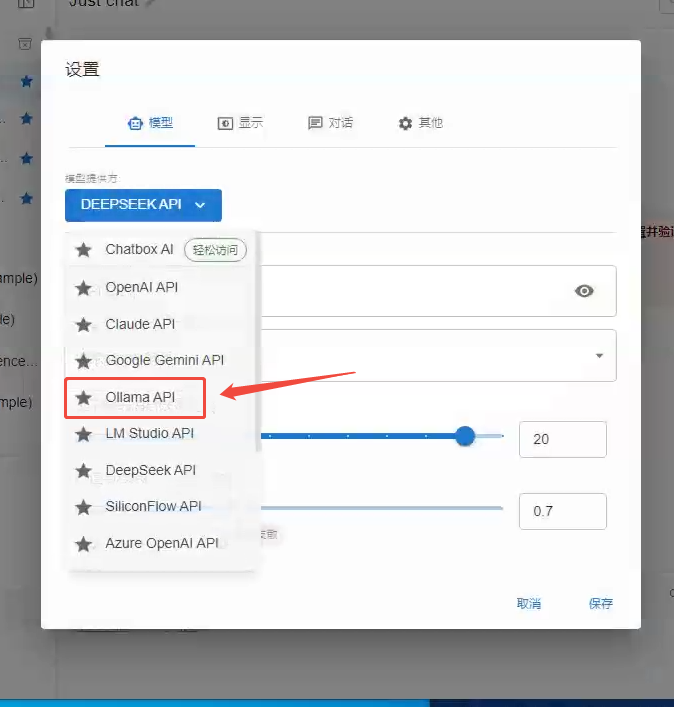

下载完成后,双击安装包进行安装。安装完成后打开 Chatbox,点击左下角的“设置”。

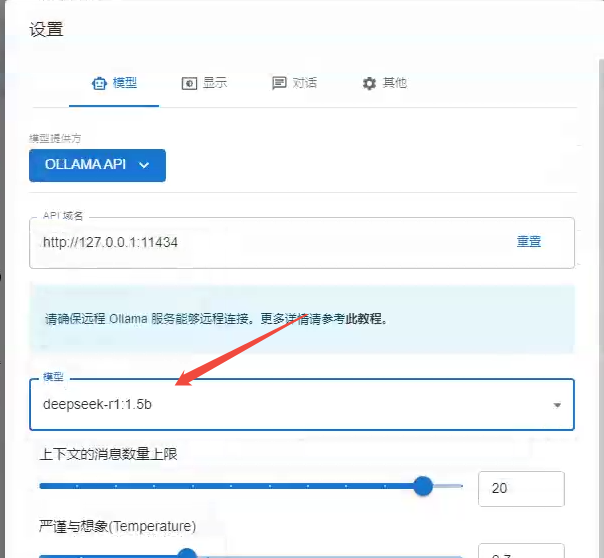

在设置中,选择“模型提供方”为

Ollama API,然后在“模型选择”中选择 deepseek-r1:1.5b(如果您安装的不是这个版本,请选择对应的版本),最后点击“保存”。

保存后,就可以通过 Chatbox 提问,查看效果了。

以上就是 DeepSeek 搭建的完整教程。如果您觉得有帮助,欢迎关注我,以便获取更多实用内容。

通过网盘分享的文件:私人搭建DeepSeek方案

链接: https://pan.baidu.com/s/10sz-_NCFe8RF1Ms_SDY5MA 提取码: 8dbv

–来自百度网盘超级会员v7的分享

链接: https://pan.baidu.com/s/10sz-_NCFe8RF1Ms_SDY5MA 提取码: 8dbv

–来自百度网盘超级会员v7的分享

微信搜索“动手派”

微信搜索“动手派”